-

Premier: il Liverpool batte il Leicester e lo fa retrocedere

Premier: il Liverpool batte il Leicester e lo fa retrocedere

-

Nicolini "il Bologna ci ha creduto, obiettivo Europa"

-

Soccorritori uccisi a Gaza, esercito israeliano ammette 'errore'

Soccorritori uccisi a Gaza, esercito israeliano ammette 'errore'

-

Zelensky, Mosca ha violato la tregua più di 2.000 volte

-

Cremlino, non è stata ordinata un'estensione della tregua

Cremlino, non è stata ordinata un'estensione della tregua

-

Inter: Inzaghi "perso gara importantissima, non lo meritavamo"

-

F1: Leclerc "oggi ottenuto il massimo, molto felice del podio"

F1: Leclerc "oggi ottenuto il massimo, molto felice del podio"

-

Piastri vince in Arabia, terzo posto per Leclerc

-

Serie A: Bologna-Inter 1-0

Serie A: Bologna-Inter 1-0

-

Sei ore Imola: vittoria della Ferrari con la 499P n.51

-

Empoli: D'Aversa, pareggio di importanza vitale

Empoli: D'Aversa, pareggio di importanza vitale

-

Atp Barcellona: Rune batte Alcaraz e vince il torneo

-

Ciclismo: Skjelmose "mi bastava il podio, vittoria incredibile"

Ciclismo: Skjelmose "mi bastava il podio, vittoria incredibile"

-

MotoGp: Martin dimesso dall'ospedale, ma resta per ora in Qatar

-

Premier: l'Arsenal vince e rinvia la festa Premier del Liverpool

Premier: l'Arsenal vince e rinvia la festa Premier del Liverpool

-

Lecce: rinnovata la fiducia all'allenatore Giampaolo

-

Serie A: Empoli-Venezia 2-2

Serie A: Empoli-Venezia 2-2

-

Skjelmose trionfa in volata nella Amstel Gold Race

-

Wta Stoccarda: Sabalenka batte Paolini e va in finale

Wta Stoccarda: Sabalenka batte Paolini e va in finale

-

Atp Monaco di Baviera: Shelton ko, Zverev vince il torneo

-

La Calabria arriva al Padiglione Italia per 7 giorni di eventi

La Calabria arriva al Padiglione Italia per 7 giorni di eventi

-

Barcellona conferma infortunio Lewandowski, silenzio su rientro

-

Il Papa all'Urbi et Orbi, condanna la corsa al riarmo

Il Papa all'Urbi et Orbi, condanna la corsa al riarmo

-

Vance dal Papa, si sono scambiati gli auguri di Pasqua

-

Lite in strada, morto diciassettenne nel Siracusano

Lite in strada, morto diciassettenne nel Siracusano

-

Orban, 'insieme alla fede superiamo qualsiasi sfida'

-

Ue, 'sosteniamo l'Ucraina in guerra e nel suo percorso europeo'

Ue, 'sosteniamo l'Ucraina in guerra e nel suo percorso europeo'

-

Zelensky, 'prima o poi ma inevitabilmente la vita trionferà'

-

Kiev, 'attacco russo nel sud dopo tregua, un morto'

Kiev, 'attacco russo nel sud dopo tregua, un morto'

-

Zelensky, Mosca non abbandona i tentativi di avanzare

-

Premier Giappone a Trump, 'sicurezza non collegata ai dazi'

Premier Giappone a Trump, 'sicurezza non collegata ai dazi'

-

Soyuz MS-26 rientra dallo spazio, atterraggio in Kazakistan

-

Meta e Amazon sponsor caccia alle uova alla Casa Bianca

Meta e Amazon sponsor caccia alle uova alla Casa Bianca

-

Casa Bianca chiede a Corte Suprema di autorizzare espulsioni

-

Due morti in una sparatoria in Germania, il killer è in fuga

Due morti in una sparatoria in Germania, il killer è in fuga

-

Usa, a Roma anche un incontro tra Witkoff e il ministro iraniano

-

Usa, 'buoni progressi nei colloqui con l'Iran a Roma'

Usa, 'buoni progressi nei colloqui con l'Iran a Roma'

-

Serie A: Roma-Verona 1-0

-

Allarme antiaereo a Kiev nonostante la tregua

Allarme antiaereo a Kiev nonostante la tregua

-

Netanyahu, 'l'Iran non avrà armi nucleari, è una promessa'

-

Conte, parleremo serenamente con il presidente

Conte, parleremo serenamente con il presidente

-

Nesta, il Monza ha fatto un'ottima gara

-

"Donne umiliate e uccise", il dolore del Papa a Pasqua

"Donne umiliate e uccise", il dolore del Papa a Pasqua

-

Vasseur "buon passo per la gara, domani tutto è possibile"

-

Tennis: Wta Stoccarda; Paolini batte Gauff e va in semifinale

Tennis: Wta Stoccarda; Paolini batte Gauff e va in semifinale

-

Zelensky, 'pronti a rispettare la tregua, se funziona va estesa'

-

Kiev, 'droni russi su Kherson, non c'è nessuna tregua'

Kiev, 'droni russi su Kherson, non c'è nessuna tregua'

-

Gp Arabia: pole di Verstappen a Gedda, Leclerc quarto

-

Gp Arabia: Norris a muro con la McLaren, bandiera rossa nella Q3

Gp Arabia: Norris a muro con la McLaren, bandiera rossa nella Q3

-

Serie A: Monza-Napoli 0-1

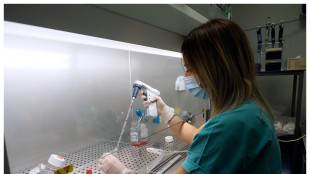

Uno studio esplora come rendere l'IA meno energivora

Pubblicazione su Jstat indaga efficacia del curriculum learning

Più biglietti della lotteria compri, maggiori sono le probabilità di vincere, ma spendere più di quanto guadagni non è una strategia saggia: qualcosa di simile accade nell'IA basata sul deep learning: più grande è una rete neurale, meglio può apprendere il compito assegnato. Purtroppo però rendere una rete infinitamente grande durante l'addestramento è impossibile e inefficiente. I cervelli biologici apprendono attraverso un processo parco nell'uso delle risorse che si è provato a imitare fornendo alle macchine un addestramento graduale, che parte da esempi semplici e progredisce verso quelli complessi (curriculum learning): una strategia sensata ma irrilevante per le reti molto grandi. Lo studio pubblicato sul Journal of Statistical Mechanics: Theory and Experiment (Jstat), uno dei giornali della Sissa/Iop, ha cercato di capire il perché di questo fallimento, suggerendo che queste reti sovraparametrizzate sono talmente ricche da sfruttare spontaneamente un percorso di apprendimento basato più sulla quantità di risorse che sulla loro qualità. Questa osservazione suggerisce che, regolando la dimensione iniziale della rete, il curriculum learning potrebbe rivelarsi una strategia valida, da sfruttare per creare reti neurali meno energeticamente dispendiose. "Ciò che abbiamo osservato è che una rete neurale sopra parametrizzata non ha bisogno di un percorso di apprendimento, perché, invece di essere guidata dagli esempi, è guidata dal fatto che dispone già di tante risorse—parametri che per caso si trovano già vicini a una soluzione, che vengono imboccati spontaneamente", osserva Luca Saglietti, fisico dell'Università Bocconi di Milano, che ha coordinato lo studio. Questo non significa che le reti non possano beneficiare del curriculum learning, ma che, data l'alta quantità di parametri iniziali, sono spinte in una direzione diversa. In teoria quindi si potrebbe trovare un modo per iniziare con reti più piccole e adottare il curriculum learning. "Questa è una parte dell'ipotesi esplorata nel nostro studio", rileva Saglietti. "Almeno negli esperimenti che abbiamo condotto, abbiamo osservato che, iniziando con reti più piccole, l'effetto del curriculum inizia a migliorare le prestazioni rispetto a quando l'input viene fornito casualmente. Questo miglioramento è maggiore rispetto a quando si continua ad aumentare i parametri fino al punto in cui l'ordine degli input non importa più".

F.Schneider--AMWN