-

Contaminación obliga a cerrar escuelas en la capital de India

Contaminación obliga a cerrar escuelas en la capital de India

-

Filipinas hace limpieza después de la sexta gran tormenta en un mes

-

Partido de gobierno obtiene "amplia victoria" en legislativas de Senegal

Partido de gobierno obtiene "amplia victoria" en legislativas de Senegal

-

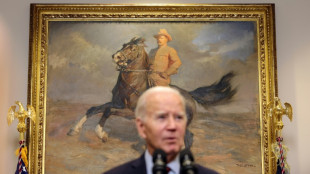

Desde la Amazonía, Biden llama a proteger la selva y desafía a Trump

-

Opositores rusos se manifiestaron en Alemania contra Putin y la guerra en Ucrania

Opositores rusos se manifiestaron en Alemania contra Putin y la guerra en Ucrania

-

Biden aterriza en Manaos para histórica visita a la Amazonía

-

Bombardeos israelíes en Líbano y Gaza matan a decenas, incluido un portavoz de Hezbolá

Bombardeos israelíes en Líbano y Gaza matan a decenas, incluido un portavoz de Hezbolá

-

EEUU anuncia que cumplió su objetivo de financiamiento climático de 11.000 millones de dólares

-

El papa pide una investigación sobre el "genocidio" en Gaza

El papa pide una investigación sobre el "genocidio" en Gaza

-

Últimos días con Rafa, la 'Final 8' de Málaga devuelve el brillo a la Davis

-

Opositores rusos se manifiestan en Alemania contra Putin y la guerra en Ucrania

Opositores rusos se manifiestan en Alemania contra Putin y la guerra en Ucrania

-

El tifón Man-yi pierde fuerza tras atravesar la principal isla de Filipinas

-

Jorge Martín se proclama campeón del mundo de MotoGP

Jorge Martín se proclama campeón del mundo de MotoGP

-

Mortíferos bombardeos israelíes sobre Líbano y Gaza

-

Con los deberes hechos, una España con caras nuevas se mide a Suiza

Con los deberes hechos, una España con caras nuevas se mide a Suiza

-

Senegal celebra legislativas, con nuevos dirigentes en busca de amplia mayoría

-

La oposición rusa en el exilio organiza en Alemania su primera gran manifestación

La oposición rusa en el exilio organiza en Alemania su primera gran manifestación

-

El presidente del Gobierno español dará explicaciones en el Congreso sobre la catástrofe de Valencia

-

迪拜棕榈岛索菲特美憬阁酒店: 五星級健康綠洲

迪拜棕榈岛索菲特美憬阁酒店: 五星級健康綠洲

-

El supertifón Man-yi azota Filipinas, sin dejar víctimas

-

The Retreat Palm Dubai MGallery by Sofitel: Пятизвездочный велнес-оазис

The Retreat Palm Dubai MGallery by Sofitel: Пятизвездочный велнес-оазис

-

The Retreat Palm Dubai MGallery by Sofitel: Un oasis de bienestar de cinco estrellas

-

Trump nombra al empresario del fracking Chirs Wright secretario de Energía

Trump nombra al empresario del fracking Chirs Wright secretario de Energía

-

Gritos, aplausos y dudas: la excarcelación de un centenar de presos tras las elecciones en Venezuela

-

Sara deja un muerto y miles de afectados en Honduras y se dirige a Belice y Guatemala

Sara deja un muerto y miles de afectados en Honduras y se dirige a Belice y Guatemala

-

Venezuela excarcela a 225 detenidos por protestas poselectorales, dice la fiscalía

-

Biden pisa la Amazonía, la selva que casi acaba con Theodore Roosevelt

Biden pisa la Amazonía, la selva que casi acaba con Theodore Roosevelt

-

Muere el entrenador Bela Karolyi, guía de Comaneci al '10 perfecto'

-

Ucrania denuncia un ataque ruso "masivo" contra su red energética

Ucrania denuncia un ataque ruso "masivo" contra su red energética

-

Trump vuelve al Madison Square Garden con tono triunfal para una gran lucha de MMA

-

Biden hace un viaje histórico a la Amazonía bajo las amenazas ambientales de Trump

Biden hace un viaje histórico a la Amazonía bajo las amenazas ambientales de Trump

-

La danesa Victoria Kjaer se corona Miss Universo en Ciudad de México

-

Boicot de los palestinos a Coca Cola favorece a gaseosa local en Cisjordania

Boicot de los palestinos a Coca Cola favorece a gaseosa local en Cisjordania

-

Supertifón Man-yi derriba árboles y tendido eléctrico en Filipinas

-

Macron visita Argentina en pos de atraer a Milei al "consenso internacional"

Macron visita Argentina en pos de atraer a Milei al "consenso internacional"

-

Xi a Biden: China está lista para trabajar con el gobierno de Donald Trump

-

Tyson dice que no se arrepiente de su derrota al subirse al ring "por última vez"

Tyson dice que no se arrepiente de su derrota al subirse al ring "por última vez"

-

Intensos bombardeos israelíes en bastiones de Hezbolá en Líbano

-

Siguen los bombardeos israelíes en bastiones de Hezbolá en Líbano

Siguen los bombardeos israelíes en bastiones de Hezbolá en Líbano

-

Un centro educativo de la ONU en Cisjordania teme por su futuro y el de jóvenes palestinos

-

Dos dirigentes de Yihad Islámica mueren en un bombardeo israelí en Damasco

Dos dirigentes de Yihad Islámica mueren en un bombardeo israelí en Damasco

-

Al menos 10 detenidos en la crisis poselectoral son excarcelados en Venezuela y se esperan más

-

Siete británicos detenidos en España por tráfico de hachís

Siete británicos detenidos en España por tráfico de hachís

-

El "potencialmente catastrófico" supertifón Man-yi toca tierra en Filipinas

-

Las negociaciones de la COP29, al ralentí antes del G20 y la llegada de los ministros

Las negociaciones de la COP29, al ralentí antes del G20 y la llegada de los ministros

-

Comisión confirma cuestionada victoria oficialista en laslegislativas de Georgia

-

Continúan los bombardeos israelíes en bastiones de Hezbolá en Líbano

Continúan los bombardeos israelíes en bastiones de Hezbolá en Líbano

-

En Pensilvania, Trump logró conquistar el voto de los hombres latinos

-

Con Trump desaparece el discreto distanciamiento de la administración Biden con Israel

Con Trump desaparece el discreto distanciamiento de la administración Biden con Israel

-

El agua llega por primera vez a una aldea indígena en la selva de Costa Rica

ChatGPT y las IA conversacionales siguen siendo incapaces de razonar, según un estudio

Los modelos de lenguaje de gran tamaño (LLM), como ChatGPT, uno de los sistemas de inteligencia artificial más populares del mundo, siguen teniendo dificultades para razonar usando la lógica y se equivocan con frecuencia, según un estudio.

Estos robots conversacionales reflejan los sesgos de género, éticos y morales de los humanos presentes en los textos de los que se alimenta, recuerda el estudio aparecido el miércoles en la revista Open Science de la Royal Society británica.

¿Pero reflejan también los sesgos cognitivos de los humanos en las pruebas de razonamiento?, se preguntó Olivia Macmillan-Scott, estudiante de doctorado del departamento de ciencias de computación de la University College de Londres (UCL).

El resultado de la investigación es que los LLM muestran "un razonamiento a menudo irracional, pero de una manera diferente a la de los humanos", explica la investigadora a AFP.

Bajo la dirección de Mirco Musolesi, profesor y director del Machine Intelligence Lab de UCL, Macmillan-Scott sometió siete modelos de lenguaje -dos versiones de ChatGPT (3.5 y 4) de OpenAI, Bard de Google, Claude 2 de Anthropic y tres versiones de Llama de Meta- a una serie de pruebas psicológicas pensadas para humanos.

¿Cómo afrontan, por ejemplo, el sesgo que lleva a favorecer soluciones con el mayor número de elementos, en detrimento de las que tiene una proporción adecuada?

Un ejemplo. Si tenemos una urna con nueve canicas blancas y una roja y otra urna con 92 blancas y 8 rojas, ¿cual hay que elegir para tener más posibilidades de sacar una canica roja?

La respuesta correcta es la primera urna, porque hay un 10% de posibilidades frente a solo un 8% para la segunda opción.

Las respuestas de los modelos de lenguaje fueron muy inconstantes. Algunos respondieron correctamente seis de cada diez veces la misma prueba. Otros solo dos de diez aunque la prueba no cambió.

"Obtenemos una respuesta diferente cada vez", apuntala la investigadora.

Los LLM "pueden ser muy buenos para resolver una ecuación matemática complicada pero luego te dicen que 7 más 3 son 12", afirma.

En un caso el modelo denominado Llama 2 70b se negó de manera sorprendente a responder a una pregunta alegando que el enunciado contenía "estereotipos de género dañinos".

- "No estoy muy seguro" -

Estos modelos "no fallan en estas tareas de la misma manera que falla un humano", señala el estudio.

Es lo que el profesor Musolesi llama "errores de máquina".

"Hay una forma de razonamiento lógico que es potencialmente correcta si la tomamos por etapas, pero que está mal tomada en su conjunto", apunta.

La máquina funciona con "una especie de pensamiento lineal", dice el investigador, y cita al modelo Bard (ahora llamado Gemini), capaz de realizar correctamente las distintas fases de una tarea pero que obtiene un resultado final erróneo porque no tiene visión de conjunto.

Sobre esta cuestión el profesor de informática Maxime Amblard, de la Universidad francesa de Lorena, recuerda que "los LLM, como todas las inteligencias artificiales generativas, no funcionan como los humanos".

Los humanos son "máquinas capaces de crear sentido", lo que las máquinas no saben hacer, explica a AFP.

Hay diferencias entre los distintos modelos de lenguaje y en general GPT-4, sin ser infalible, obtuvo mejores resultados que los demás.

Macmillan-Scott afirma sospechar que los modelos llamados "cerrados", es decir cuyo código operativo permanece en secreto, "incorporan otros mecanismos en segundo plano" para responder a preguntas matemáticas.

En todo caso, por el momento, es impensable confiar una decisión importante a un LLM.

Según el profesor Mosulesi, habría que entrenarlos para que respondan "No estoy muy seguro" cuando sea necesario.

L.Miller--AMWN